Mantenerse al día con una industria que evoluciona tan rápidamente como la IA es una tarea difícil. Entonces, hasta que una IA pueda hacerlo por usted, aquí hay un resumen útil de historias recientes en el mundo del aprendizaje automático, junto con investigaciones y experimentos notables que no cubrimos por sí solos.

Esta semana en IA, Google detuvo la capacidad de su chatbot de IA Gemini para generar imágenes de personas después de que un segmento de usuarios se quejara de imprecisiones históricas. Cuando se le pedía que representara “una legión romana”, por ejemplo, Géminis mostraría un grupo anacrónico y caricaturesco de soldados de infantería racialmente diversos mientras representaba a los “guerreros zulúes” como negros.

Parece que Google, al igual que otros proveedores de inteligencia artificial, incluido OpenAI, había implementado una codificación torpe bajo el capó para intentar “corregir” los sesgos en su modelo. En respuesta a indicaciones como “muéstrame imágenes sólo de mujeres” o “muéstrame imágenes sólo de hombres”, Géminis se negaba, afirmando que tales imágenes podrían “contribuir a la exclusión y marginación de otros géneros”. Géminis también se resistía a generar imágenes de personas identificadas únicamente por su raza (por ejemplo, “gente blanca” o “gente negra”) por una aparente preocupación por “reducir a los individuos a sus características físicas”.

Los derechistas se han aferrado a los errores como evidencia de una agenda “despertada” perpetuada por la élite tecnológica. Pero no hace falta la navaja de Occam para ver la verdad menos nefasta: Google, quemado antes por los prejuicios de sus herramientas (ver: clasificar a los hombres negros como gorilas, confundir las pistolas térmicas en manos de los negros con armas, etc.), está tan desesperado para evitar que la historia se repita, que está manifestando un mundo menos sesgado en sus modelos de generación de imágenes, por erróneos que sean.

En su libro más vendido “White Fragility”, la educadora antirracista Robin DiAngelo escribe sobre cómo la eliminación de la raza (“daltonismo”, según otra frase) contribuye a los desequilibrios sistémicos de poder racial en lugar de mitigarlos o aliviarlos. Al pretender “no ver el color” o al reforzar la noción de que simplemente reconocer la lucha de personas de otras razas es suficiente para etiquetarse a uno mismo como “despertado”, la gente perpetuar daño al evitar cualquier conservación sustancial sobre el tema, dice DiAngelo.

El tratamiento cauteloso que Google dio a las indicaciones basadas en la raza en Gemini no evitó el problema per se, pero intentó ocultar falsamente lo peor de los sesgos del modelo. Se podría argumentar (y muchos lo han hecho) que estos sesgos no deberían ignorarse ni pasarse por alto, sino abordarse en el contexto más amplio de los datos de capacitación de los que surgen: es decir, la sociedad en la red mundial.

Sí, los conjuntos de datos utilizados para entrenar a los generadores de imágenes generalmente contienen más personas blancas que negras, y sí, las imágenes de personas negras en esos conjuntos de datos refuerzan los estereotipos negativos. Es por eso que los generadores de imágenes sexualizan a ciertas mujeres de color, representan a hombres blancos en posiciones de autoridad y, en general, favorecen las perspectivas occidentales adineradas.

Algunos podrían argumentar que los proveedores de IA no salen ganando. Ya sea que aborden (o decidan no abordar) los sesgos de los modelos, serán criticados. Y eso es verdad. Pero sostengo que, en cualquier caso, estos modelos carecen de explicación y están presentados de una manera que minimiza las formas en que se manifiestan sus sesgos.

Si los proveedores de IA abordaran las deficiencias de sus modelos de frente, en un lenguaje humilde y transparente, irían mucho más allá de los intentos fortuitos de “arreglar” lo que es esencialmente un sesgo irreparable. La verdad es que todos tenemos prejuicios y, como resultado, no tratamos a las personas de la misma manera. Tampoco los modelos que estamos construyendo. Y haríamos bien en reconocerlo.

Aquí hay algunas otras historias destacadas de IA de los últimos días:

- Mujeres en IA: TechCrunch lanzó una serie que destaca a mujeres destacadas en el campo de la IA. Lea la lista aquí.

- Difusión estable v3: Stability AI ha anunciado Stable Diffusion 3, la versión más reciente y potente del modelo de IA de generación de imágenes de la compañía, basado en una nueva arquitectura.

- Chrome obtiene GenAI: La nueva herramienta Gemini de Google en Chrome permite a los usuarios reescribir texto existente en la web o generar algo completamente nuevo.

- Más negro que ChatGPT: La agencia de publicidad creativa McKinney desarrolló un juego de preguntas, ¿Eres más negro que ChatGPT?, para arrojar luz sobre el sesgo de la IA.

- Convocatorias de leyes: Cientos de luminarias de la IA firmaron una carta pública a principios de esta semana pidiendo una legislación contra los deepfake en EE. UU.

- Partido realizado en IA: OpenAI tiene un nuevo cliente en Match Group, propietario de aplicaciones como Hinge, Tinder y Match, cuyos empleados utilizarán la tecnología de inteligencia artificial de OpenAI para realizar tareas relacionadas con el trabajo.

- Seguridad de DeepMind: DeepMind, la división de investigación de IA de Google, ha formado una nueva organización, AI Safety and Alignment, formada por equipos existentes que trabajan en la seguridad de la IA, pero que también se amplió para abarcar cohortes nuevas y especializadas de investigadores e ingenieros de GenAI.

- Modelos abiertos: Apenas una semana después de lanzar la última versión de sus modelos Gemini, Google lanzó Gemma, una nueva familia de modelos livianos y abiertos.

- Grupo de trabajo de la casa: La Cámara de Representantes de Estados Unidos ha fundado un grupo de trabajo sobre IA que, como escribe Devin, parece una apuesta después de años de indecisión que no dan señales de terminar.

Más aprendizajes automáticos

Los modelos de IA parecen saber mucho, pero ¿qué saben realmente? Bueno, la respuesta es nada. Pero si formulas la pregunta de manera ligeramente diferente… parecen haber internalizado algunos “significados” que son similares a lo que los humanos conocen. Aunque ninguna IA entiende realmente qué es un gato o un perro, ¿podría tener algún sentido de similitud codificado en la incorporación de esas dos palabras que sea diferente de, digamos, gato y botella? Los investigadores de Amazon así lo creen.

Su investigación comparó las “trayectorias” de oraciones similares pero distintas, como “el perro le ladró al ladrón” y “el ladrón hizo que el perro ladrara”, con aquellas de oraciones gramaticalmente similares pero diferentes, como “un gato duerme todo el día”. y “una chica trota toda la tarde”. Descubrieron que aquellos que los humanos encontrarían similares eran tratados internamente como más similares a pesar de ser gramaticalmente diferentes, y viceversa para los gramaticalmente similares. Bien, siento que este párrafo fue un poco confuso, pero basta decir que los significados codificados en los LLM parecen ser más sólidos y sofisticados de lo esperado, no totalmente ingenuos.

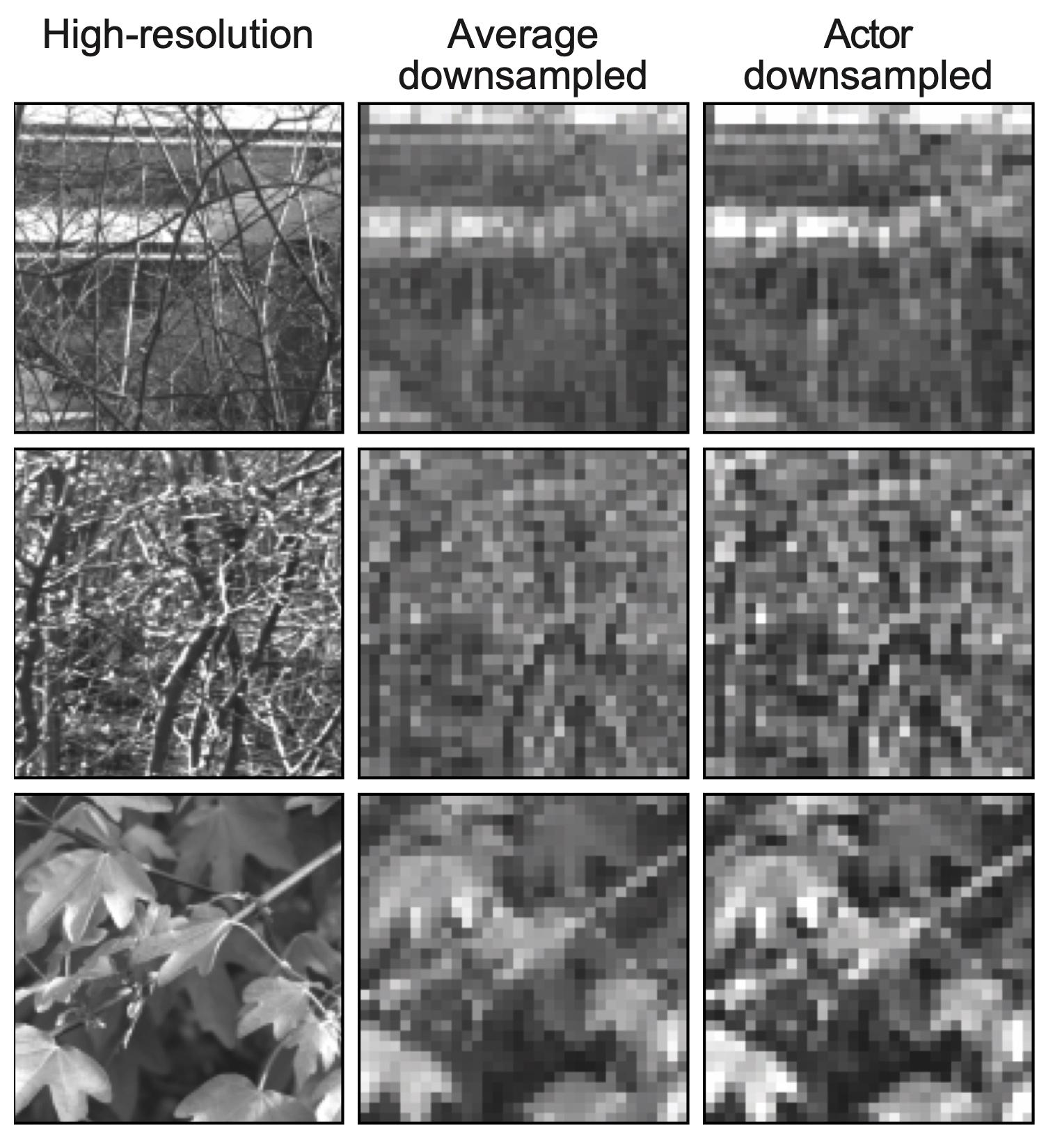

La codificación neuronal está resultando útil en la visión protésica, según han descubierto investigadores suizos de la EPFL. Las retinas artificiales y otras formas de reemplazar partes del sistema visual humano generalmente tienen una resolución muy limitada debido a las limitaciones de las matrices de microelectrodos. Por lo tanto, no importa cuán detallada sea la imagen, debe transmitirse con una fidelidad muy baja. Pero hay diferentes formas de reducir la resolución y este equipo descubrió que el aprendizaje automático hace un gran trabajo al respecto.

Créditos de imagen: EPFL

“Descubrimos que si aplicábamos un enfoque basado en el aprendizaje, obteníamos mejores resultados en términos de codificación sensorial optimizada. Pero lo más sorprendente fue que cuando utilizamos una red neuronal sin restricciones, aprendió a imitar aspectos del procesamiento de la retina por sí sola”, dijo Diego Ghezzi en un comunicado de prensa. Básicamente, hace compresión perceptiva. Lo probaron en retinas de ratones, por lo que no es sólo teórico.

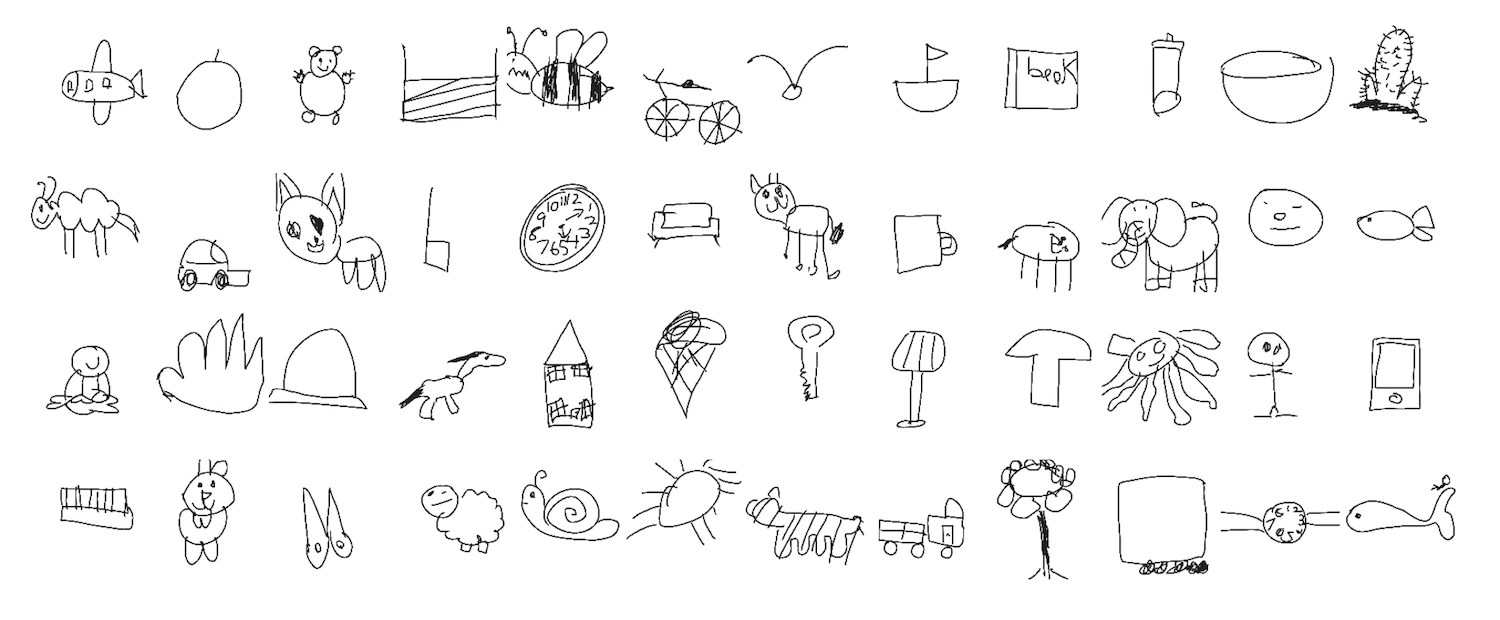

Una interesante aplicación de la visión por computadora realizada por investigadores de Stanford insinúa un misterio sobre cómo los niños desarrollan sus habilidades de dibujo. El equipo solicitó y analizó 37.000 dibujos de niños de diversos objetos y animales, y también (según las respuestas de los niños) qué tan reconocible era cada dibujo. Curiosamente, no fue sólo la inclusión de características distintivas, como las orejas de un conejo, lo que hizo que los dibujos fueran más reconocibles para otros niños.

“Los tipos de características que hacen que los dibujos de niños mayores sean reconocibles no parecen estar impulsados por una sola característica que todos los niños mayores aprenden a incluir en sus dibujos. Es algo mucho más complejo que estos sistemas de aprendizaje automático están detectando”, afirmó la investigadora principal Judith Fan.

Los químicos (también de la EPFL) descubrieron que los LLM también son sorprendentemente hábiles para ayudar con su trabajo después de una formación mínima. No se trata sólo de hacer química directamente, sino de perfeccionar un conjunto de trabajos que los químicos individualmente no pueden conocer en su totalidad. Por ejemplo, en miles de artículos puede haber unos cientos de afirmaciones sobre si una aleación de alta entropía es monofásica o multifásica (no es necesario que sepas lo que esto significa, ellos sí lo saben). El sistema (basado en GPT-3) se puede entrenar en este tipo de preguntas y respuestas de sí/no, y pronto podrá extrapolar a partir de eso.

No se trata de un gran avance, sólo de una prueba más de que los LLM son una herramienta útil en este sentido. “La cuestión es que esto es tan fácil como hacer una búsqueda bibliográfica, lo que funciona para muchos problemas químicos”, dijo el investigador Berend Smit. “Consultar un modelo fundamental podría convertirse en una forma rutinaria de iniciar un proyecto”.

Por último, una advertencia por parte de los investigadores de Berkeley, aunque ahora que estoy leyendo la publicación nuevamente veo que la EPFL también estuvo involucrada en esto. ¡Vaya Lausana! El grupo descubrió que las imágenes encontradas a través de Google tenían muchas más probabilidades de imponer estereotipos de género para ciertos trabajos y palabras que los textos que mencionaban lo mismo. Y también hubo muchos más hombres presentes en ambos casos.

No solo eso, sino que en un experimento descubrieron que las personas que veían imágenes en lugar de leer texto cuando investigaban un rol asociaban esos roles con un género de manera más confiable, incluso días después. “No se trata sólo de la frecuencia del prejuicio de género en línea”, dijo el investigador Douglas Guilbeault. “Parte de la historia aquí es que hay algo muy pegajoso, muy potente en la representación de personas en las imágenes que el texto simplemente no tiene”.

Con cosas como la pelea por la diversidad del generador de imágenes de Google, es fácil perder de vista el hecho establecido y frecuentemente verificado de que la fuente de datos para muchos modelos de IA muestra un sesgo grave, y este sesgo tiene un efecto real en las personas.