Mantenerse al día con una industria que evoluciona tan rápidamente como la IA es una tarea difícil. Entonces, hasta que una IA pueda hacerlo por usted, aquí hay un resumen útil de historias recientes en el mundo del aprendizaje automático, junto con investigaciones y experimentos notables que no cubrimos por sí solos.

Esta semana, Meta lanzó lo último de su serie Llama de modelos de IA generativa: Llama 3 8B y Llama 3 70B. Capaces de analizar y escribir texto, los modelos son de “código abierto”, dijo Meta, y están destinados a ser una “pieza fundamental” de los sistemas que los desarrolladores diseñan con sus objetivos únicos en mente.

“Creemos que estos son los mejores modelos de código abierto de su clase, punto”, escribió Meta en una publicación de blog. “Estamos adoptando el espíritu de código abierto de realizar lanzamientos tempranos y frecuentes”.

Sólo hay un problema: los modelos Llama 3 no lo son en realidad “código abierto”, al menos no en la definición más estricta.

El código abierto implica que los desarrolladores pueden utilizar los modelos como quieran, sin restricciones. Pero en el caso de Llama 3, al igual que con Llama 2, Meta ha impuesto ciertas restricciones de licencia. Por ejemplo, los modelos Llama no se pueden usar para entrenar otros modelos. Y Los desarrolladores de aplicaciones con más de 700 millones de usuarios mensuales deben solicitar una licencia especial a Meta.

Los debates sobre la definición de código abierto no son nuevos. Pero a medida que las empresas en el espacio de la IA juegan rápido y libremente con el término, está inyectando combustible a argumentos filosóficos de larga data.

En agosto pasado, un estudio del que fueron coautores investigadores de Carnegie Mellon, el AI Now Institute y la Signal Foundation descubrió que muchos modelos de IA catalogados como de “código abierto” conllevan grandes inconvenientes, no solo Llama. Los datos necesarios para entrenar los modelos se mantienen en secreto. La potencia informática necesaria para ejecutarlos está fuera del alcance de muchos desarrolladores. Y la mano de obra necesaria para perfeccionarlos es prohibitivamente cara.

Entonces, si estos modelos no son verdaderamente de código abierto, ¿qué son exactamente? Buena pregunta; Definir el código abierto con respecto a la IA no es una tarea fácil.

Una cuestión pertinente y no resuelta es si los derechos de autor, el mecanismo fundamental de propiedad intelectual en el que se basan las licencias de código abierto, se pueden aplicar a los distintos componentes y piezas de un proyecto de IA, en particular a la estructura interna de un modelo (por ejemplo, incrustaciones). Luego, está la discrepancia entre la percepción del código abierto y cómo funciona realmente la IA para superarlo: el código abierto se ideó en parte para garantizar que los desarrolladores pudieran estudiar y modificar el código sin restricciones. Sin embargo, con la IA, qué ingredientes necesita para estudiar y modificar está abierto a interpretación.

Atravesando toda la incertidumbre, el estudio Carnegie Mellon hace dejar en claro el daño inherente a que gigantes tecnológicos como Meta coopten la frase “código abierto”.

A menudo, los proyectos de IA de “código abierto” como Llama terminan iniciando ciclos de noticias (marketing gratuito) y brindando beneficios técnicos y estratégicos a quienes mantienen los proyectos. La comunidad de código abierto rara vez ve estos mismos beneficios y, cuando los ven, son marginales en comparación con los de quienes los mantienen.

En lugar de democratizar la IA, los proyectos de IA de “código abierto” (especialmente los de las grandes empresas tecnológicas) tienden a afianzar y expandir el poder centralizado, dicen los coautores del estudio. Es bueno tenerlo en cuenta la próxima vez que se lance un modelo importante de “código abierto”.

Aquí hay algunas otras historias destacadas de IA de los últimos días:

- Meta actualiza su chatbot: Coincidiendo con el debut de Llama 3, Meta actualizó su chatbot de IA en Facebook, Messenger, Instagram y WhatsApp (Meta AI) con un backend impulsado por Llama 3. También lanzó nuevas funciones, incluida una generación de imágenes más rápida y acceso a resultados de búsqueda web.

- Porno generado por IA: Ivan escribe sobre cómo la Junta de Supervisión, el consejo político semiindependiente de Meta, está centrando su atención en cómo las plataformas sociales de la empresa manejan imágenes explícitas generadas por IA.

- Marcas de agua instantáneas: El servicio de redes sociales Snap planea agregar marcas de agua a las imágenes generadas por IA en su plataforma. Una versión translúcida del logotipo de Snap con un emoji brillante, la nueva marca de agua se agregará a cualquier imagen generada por IA exportada desde la aplicación o guardada en el carrete de la cámara.

- El nuevo Atlas: La empresa de robótica Boston Dynamics, propiedad de Hyundai, ha presentado su robot humanoide Atlas de próxima generación que, a diferencia de su predecesor impulsado por sistemas hidráulicos, es totalmente eléctrico y mucho más amigable en apariencia.

- Humanoides sobre humanoides: Para no quedarse atrás con Boston Dynamics, el fundador de Mobileye, Amnon Shashua, lanzó una nueva startup, Menteebot, centrada en la construcción de sistemas robóticos bibedales. Un vídeo de demostración muestra el prototipo de Menteebot acercándose a una mesa y recogiendo fruta.

- Reddit, traducido: En una entrevista con Amanda, el CPO de Reddit, Pali Bhat, reveló que se está trabajando en una función de traducción de idiomas basada en inteligencia artificial para llevar la red social a una audiencia más global, junto con una herramienta de moderación asistida capacitada en las decisiones y acciones pasadas de los moderadores de Reddit.

- Contenido de LinkedIn generado por IA: LinkedIn ha comenzado a probar discretamente una nueva forma de aumentar sus ingresos: una suscripción a la página de empresa premium de LinkedIn, que (por tarifas que parecen tan elevadas como 99 dólares al mes) incluye inteligencia artificial para escribir contenido y un conjunto de herramientas para aumentar el número de seguidores.

- Un referente: X, la fábrica de lanzamiento a la luna de Alphabet, matriz de Google, presentó esta semana el Proyecto Bellwether, su última apuesta para aplicar tecnología a algunos de los mayores problemas del mundo. En este caso, eso significa utilizar herramientas de inteligencia artificial para identificar desastres naturales como incendios forestales e inundaciones lo más rápido posible.

- Proteger a los niños con IA: Ofcom, el regulador encargado de hacer cumplir la Ley de Seguridad en Línea del Reino Unido, planea lanzar una exploración sobre cómo se puede utilizar la IA y otras herramientas automatizadas para detectar y eliminar de manera proactiva contenido ilegal en línea, específicamente para proteger a los niños de contenido dañino.

- OpenAI aterriza en Japón: OpenAI se está expandiendo a Japón con la apertura de una nueva oficina en Tokio y planes para un modelo GPT-4 optimizado específicamente para el idioma japonés.

Más aprendizajes automáticos

Créditos de imagen: DrAfter123 / Getty Images

¿Puede un chatbot hacerte cambiar de opinión? Investigadores suizos descubrieron que no sólo pueden hacerlo, sino que si están previamente armados con cierta información personal sobre usted, en realidad pueden ser más más persuasivo en un debate que un humano con la misma información.

“Esto es Cambridge Analytica con esteroides”, dijo el líder del proyecto, Robert West, de la EPFL. Los investigadores sospechan que el modelo (GPT-4 en este caso) se basó en su gran cantidad de argumentos y hechos en línea para presentar un caso más convincente y seguro. Pero el resultado habla por sí solo. No subestimes el poder de los LLM en cuestiones de persuasión, advirtió West: “En el contexto de las próximas elecciones estadounidenses, la gente está preocupada porque es ahí donde este tipo de tecnología siempre se prueba por primera vez. Una cosa que sabemos con certeza es que la gente utilizará el poder de los grandes modelos lingüísticos para intentar influir en las elecciones”.

¿Por qué estos modelos son tan buenos en el lenguaje? Ésa es un área en la que existe una larga historia de investigación, que se remonta a ELIZA. Si tiene curiosidad acerca de una de las personas que ha estado allí durante mucho tiempo (y que él mismo realizó una cantidad considerable), consulte este perfil de Christopher Manning de Stanford. Le acaban de conceder la medalla John von Neuman; ¡felicitaciones!

En una entrevista con un título provocativo, otro investigador de IA desde hace mucho tiempo (que también ha aparecido en el escenario de TechCrunch), Stuart Russell, y el postdoctorado Michael Cohen especulan sobre “Cómo evitar que la IA nos mate a todos”. ¡Probablemente sea bueno descubrirlo más temprano que tarde! Sin embargo, no es una discusión superficial: son personas inteligentes las que hablan de cómo podemos entender realmente las motivaciones (si esa es la palabra correcta) de los modelos de IA y cómo se deben elaborar regulaciones en torno a ellos.

En realidad, la entrevista se refiere a un artículo en Science publicado a principios de este mes, en el que proponen que las IA avanzadas capaces de actuar estratégicamente para lograr sus objetivos, a las que llaman “agentes de planificación a largo plazo”, pueden ser imposibles de probar. Esencialmente, si un modelo aprende a “comprender” las pruebas que debe pasar para tener éxito, es muy posible que aprenda formas de negar o eludir creativamente esas pruebas. Lo hemos visto a pequeña escala, ¿por qué no a gran escala?

Russell propone restringir el hardware necesario para fabricar dichos agentes… pero, por supuesto, Los Alamos y Sandia National Labs acaban de recibir sus entregas. LANL acaba de celebrar la ceremonia de inauguración de Venado, una nueva supercomputadora destinada a la investigación de IA, compuesta por 2.560 chips Grace Hopper Nvidia.

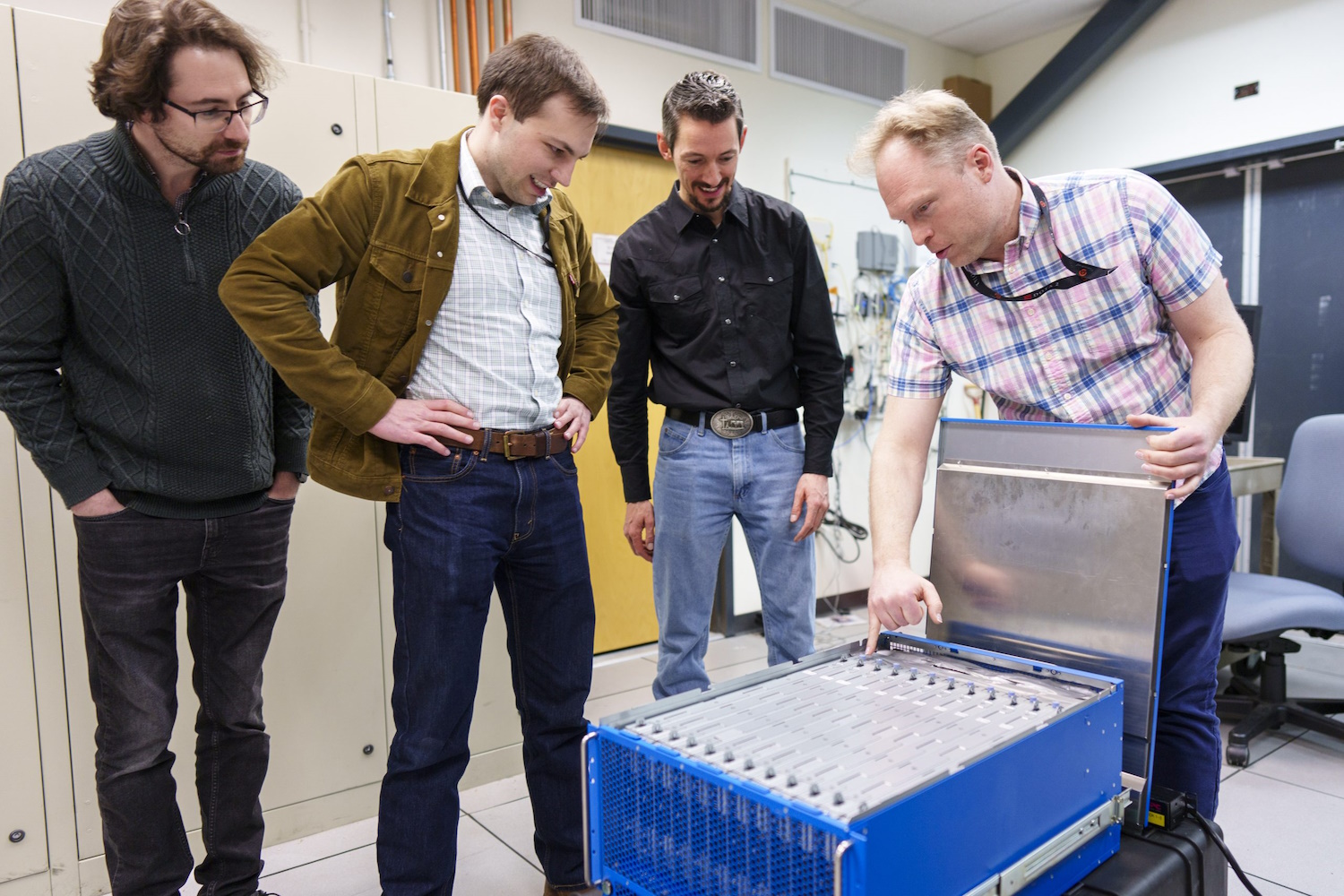

Los investigadores analizan la nueva computadora neuromórfica.

Y Sandia acaba de recibir “un extraordinario sistema informático basado en el cerebro llamado Hala Point”, con 1.150 millones de neuronas artificiales, construido por Intel y que se cree que es el sistema de este tipo más grande del mundo. La computación neuromórfica, como se la llama, no pretende reemplazar sistemas como Venado, sino buscar nuevos métodos de computación que se parezcan más al cerebro que el enfoque centrado en estadísticas que vemos en los modelos modernos.

“Con este sistema de mil millones de neuronas, tendremos la oportunidad de innovar a escala tanto en nuevos algoritmos de IA que pueden ser más eficientes e inteligentes que los algoritmos existentes, como en nuevos enfoques similares a los del cerebro para los algoritmos informáticos existentes, como la optimización y el modelado”, afirmó. Brad Aimone, investigador de Sandia. Suena excelente… ¡simplemente excelente!