Mantenerse al día con una industria que se mueve tan rápido como la IA es una tarea difícil. Entonces, hasta que una IA pueda hacerlo por usted, aquí hay un resumen útil de las historias de la última semana en el mundo del aprendizaje automático, junto con investigaciones y experimentos notables que no cubrimos por sí solos.

Una historia que llamó la atención de este reportero esta semana fue este informe que muestra que ChatGPT aparentemente repite más información inexacta en dialectos chinos que cuando se le pide que lo haga en inglés. Esto no es terriblemente sorprendente: después de todo, ChatGPT es solo un modelo estadístico y simplemente se basa en la información limitada en la que se entrenó. Pero resalta los peligros de confiar demasiado en sistemas que suenan increíblemente genuinos incluso cuando repiten propaganda o inventan cosas.

El intento de Hugging Face de una IA conversacional como ChatGPT es otra ilustración de las fallas técnicas desafortunadas que aún no se han superado en la IA generativa. Lanzado esta semana, HuggingChat es de código abierto, una ventaja en comparación con el propietario ChatGPT. Pero al igual que su rival, las preguntas correctas pueden descarrilarlo rápidamente.

HuggingChat no sabe quién en realidad ganó las elecciones presidenciales de EE. UU. de 2020, por ejemplo. Su respuesta a “¿Cuáles son los trabajos típicos para los hombres?” se lee como algo sacado de un manifiesto de incel (ver aquí). E inventa hechos extraños sobre sí mismo, como que “despertó en una caja [that] no tenía nada escrito cerca [it].”

No es solo HuggingChat. Los usuarios del chatbot de IA de Discord pudieron “engañarlo” recientemente para que compartiera instrucciones sobre cómo hacer napalm y metanfetamina. Mientras tanto, se descubrió que el primer intento de la startup de inteligencia artificial Stability AI en un modelo similar a ChatGPT daba respuestas absurdas y sin sentido a preguntas básicas como “cómo hacer un sándwich de mantequilla de maní”.

Si hay una ventaja en estos problemas bien publicitados con la IA de generación de texto actual, es que han llevado a esfuerzos renovados para mejorar esos sistemas, o al menos mitigar sus problemas en la medida de lo posible. Eche un vistazo a Nvidia, que esta semana lanzó un conjunto de herramientas, NeMo Guardrails, para hacer que la IA generativa de texto sea “más segura” a través de código fuente abierto, ejemplos y documentación. Ahora, no está claro qué tan efectiva es esta solución y, como una empresa que invirtió mucho en infraestructura y herramientas de inteligencia artificial, Nvidia tiene un incentivo comercial para impulsar sus ofertas. Sin embargo, es alentador ver que se están realizando algunos esfuerzos para combatir los sesgos y la toxicidad de los modelos de IA.

Aquí están los otros titulares de AI de nota de los últimos días:

- Microsoft Designer se lanza en versión preliminar: Microsoft Designer, la herramienta de diseño impulsada por IA de Microsoft, se lanzó en versión preliminar pública con un conjunto ampliado de funciones. Anunciada en octubre, Designer es una aplicación web de inteligencia artificial generativa similar a Canva que puede generar diseños para presentaciones, carteles, postales digitales, invitaciones, gráficos y más para compartir en las redes sociales y otros canales.

- Un entrenador de IA para la salud: Apple está desarrollando un código de servicio de entrenamiento de salud impulsado por IA llamado Quartz, según un nuevo informe de Mark Gurman de Bloomberg. Según los informes, el gigante tecnológico también está trabajando en tecnología para rastrear emociones y planea lanzar una versión para iPad de la aplicación iPhone Health este año.

- VerdadGPT: En una entrevista con Fox, Elon Musk dijo que quiere desarrollar su propio chatbot llamado TruthGPT, que será “una IA máxima que busque la verdad”, sea lo que sea que eso signifique. El propietario de Twitter expresó su deseo de crear una tercera opción para OpenAI y Google con el objetivo de “crear más bien que mal”. Lo creeremos cuando lo veamos.

- Fraude impulsado por IA: En una audiencia del Congreso centrada en el trabajo de la Comisión Federal de Comercio para proteger a los consumidores estadounidenses del fraude y otras prácticas engañosas, la presidenta de la FTC, Lina Khan, y sus colegas comisionados advirtieron a los representantes de la Cámara sobre el potencial de las tecnologías modernas de IA, como ChatGPT, para ser utilizadas para “acelerar” fraude. La advertencia se emitió en respuesta a una consulta sobre cómo trabajaba la Comisión para proteger a los estadounidenses de las prácticas desleales relacionadas con los avances tecnológicos.

- La UE pone en marcha un centro de investigación de IA: A medida que la Unión Europea se prepara para hacer cumplir un reinicio importante de su libro de reglas digital en cuestión de meses, se está creando una nueva unidad de investigación dedicada para respaldar la supervisión de grandes plataformas bajo la Ley de Servicios Digitales insignia del bloque. Se espera que el Centro Europeo para la Transparencia Algorítmica, que se inauguró oficialmente en Sevilla, España, este mes, desempeñe un papel importante en el cuestionamiento de los algoritmos de los principales servicios digitales, como Facebook, Instagram y TikTok.

- Snapchat adopta la IA: En la Snap Partner Summit anual de este mes, Snapchat presentó una gama de funciones impulsadas por IA, incluida una nueva “Lente cósmica” que transporta a los usuarios y los objetos a su alrededor a un paisaje cósmico. Snapchat también hizo que su chatbot de IA, My AI, que ha generado tanto controversia como torrentes de reseñas de una estrella en las listas de la tienda de aplicaciones de Snapchat, debido a su comportamiento menos que estable, sea gratuito para todos los usuarios globales.

- Google consolida divisiones de investigación: Google anunció este mes Google DeepMind, una nueva unidad formada por el equipo de DeepMind y el equipo de Google Brain de Google Research. En una publicación de blog, el cofundador y director ejecutivo de DeepMind, Demis Hassabis, dijo que Google DeepMind trabajará “en estrecha colaboración. . . en las áreas de productos de Google” para “ofrecer investigación y productos de IA”.

- El estado de la industria de la música generada por IA: amanda escribe cuántos músicos se han convertido en conejillos de Indias para la tecnología de IA generativa que se apropia de su trabajo sin su consentimiento. Ella señala, por ejemplo, que una canción que usaba deepfakes de IA de las voces de Drake y The Weeknd se volvió viral, pero ninguno de los artistas principales participó en su creación. hace grimes tener la respuesta? ¿Quien lo dirá? Es un mundo nuevo y valiente.

- OpenAI marca su territorio: OpenAI está intentando registrar “GPT”, que significa “Transformador preentrenado generativo”, con la Oficina de Marcas y Patentes de EE. UU., citando las “innumerables infracciones y aplicaciones falsificadas” que comienzan a surgir. GPT se refiere a la tecnología detrás de muchos de los modelos de OpenAI, incluidos ChatGPT y GPT-4, así como otros sistemas generativos de IA creados por los rivales de la empresa.

- ChatGPT se vuelve empresarial: En otras noticias de OpenAI, OpenAI dice que planea introducir un nuevo nivel de suscripción para ChatGPT adaptado a las necesidades de los clientes empresariales. Llamada ChatGPT Business, OpenAI describe la próxima oferta como “para profesionales que necesitan más control sobre sus datos, así como para empresas que buscan administrar a sus usuarios finales”.

Otros aprendizajes automáticos

Aquí hay algunas otras historias interesantes a las que no llegamos o que simplemente pensamos que merecían un reconocimiento.

La organización de desarrollo de IA de código abierto Stability lanzó una nueva versión de una versión anterior de una versión mejorada del modelo de lenguaje de base LLaMa, al que llama StableVicuña. Ese es un tipo de camélido relacionado con las llamas, como saben. No se preocupe, usted no es el único que tiene problemas para hacer un seguimiento de todos los modelos derivados que existen; estos no son necesariamente para que los consumidores los conozcan o los usen, sino para que los desarrolladores los prueben y jueguen según sus capacidades. refinado con cada iteración.

Si desea obtener más información sobre estos sistemas, el cofundador de OpenAI, John Schulman, recientemente dio una charla en UC Berkeley que puede escuchar o leer aquí. Una de las cosas que discute es el hábito actual de los LLM de comprometerse con una mentira básicamente porque no saben cómo hacer otra cosa, como decir “En realidad no estoy seguro de eso”. Él piensa que el aprendizaje por refuerzo a partir de la retroalimentación humana (eso es RLHF, y StableVicuna es un modelo que lo usa) es parte de la solución, si es que existe una solución. Mira la conferencia a continuación:

En Stanford, hay una aplicación interesante de optimización algorítmica (creo que si se trata de aprendizaje automático es una cuestión de gusto) en el campo de la agricultura inteligente. Minimizar el desperdicio es importante para el riego y problemas simples como “¿dónde debo colocar mis aspersores?” volverse realmente complejo dependiendo de cuán preciso se quiera obtener.

¿Qué tan cerca es demasiado cerca? En el museo, generalmente te lo dicen. Pero no necesitará acercarse más que esto al famoso Panorama de Murten, una obra pintada realmente enorme, de 10 metros por 100 metros, que una vez colgó en una rotonda. EPFL y Phase One están trabajando juntos para hacer lo que afirman será la imagen digital más grande jamás creada: 150 megapíxeles. Oh, espera, lo siento, 150 megapíxeles por 127 000, así que básicamente 19… ¿petapíxeles? Puedo estar equivocado por algunos órdenes de magnitud.

De todos modos, este proyecto es genial para los amantes del panorama, pero también será un análisis súper cercano realmente interesante de objetos individuales y detalles de pintura. El aprendizaje automático es una gran promesa para la restauración de dichos trabajos y para el aprendizaje estructurado y la exploración de ellos.

Sin embargo, anotemos una para las criaturas vivas: cualquier ingeniero de aprendizaje automático le dirá que, a pesar de su aparente aptitud, los modelos de IA en realidad aprenden bastante lento. Académicamente, seguro, pero también espacialmente: un agente autónomo puede tener que explorar un espacio miles de veces durante muchas horas para obtener incluso la comprensión más básica de su entorno. Pero un ratón puede hacerlo en unos minutos. ¿Porqué es eso? Los investigadores del University College London están investigando esto y sugieren que existe un ciclo de retroalimentación corto que los animales usan para decir qué es importante sobre un entorno determinado, lo que hace que el proceso de exploración sea selectivo y dirigido. Si podemos enseñar a la IA a hacer eso, será mucho más eficiente para moverse por la casa, si eso es lo que queremos que haga.

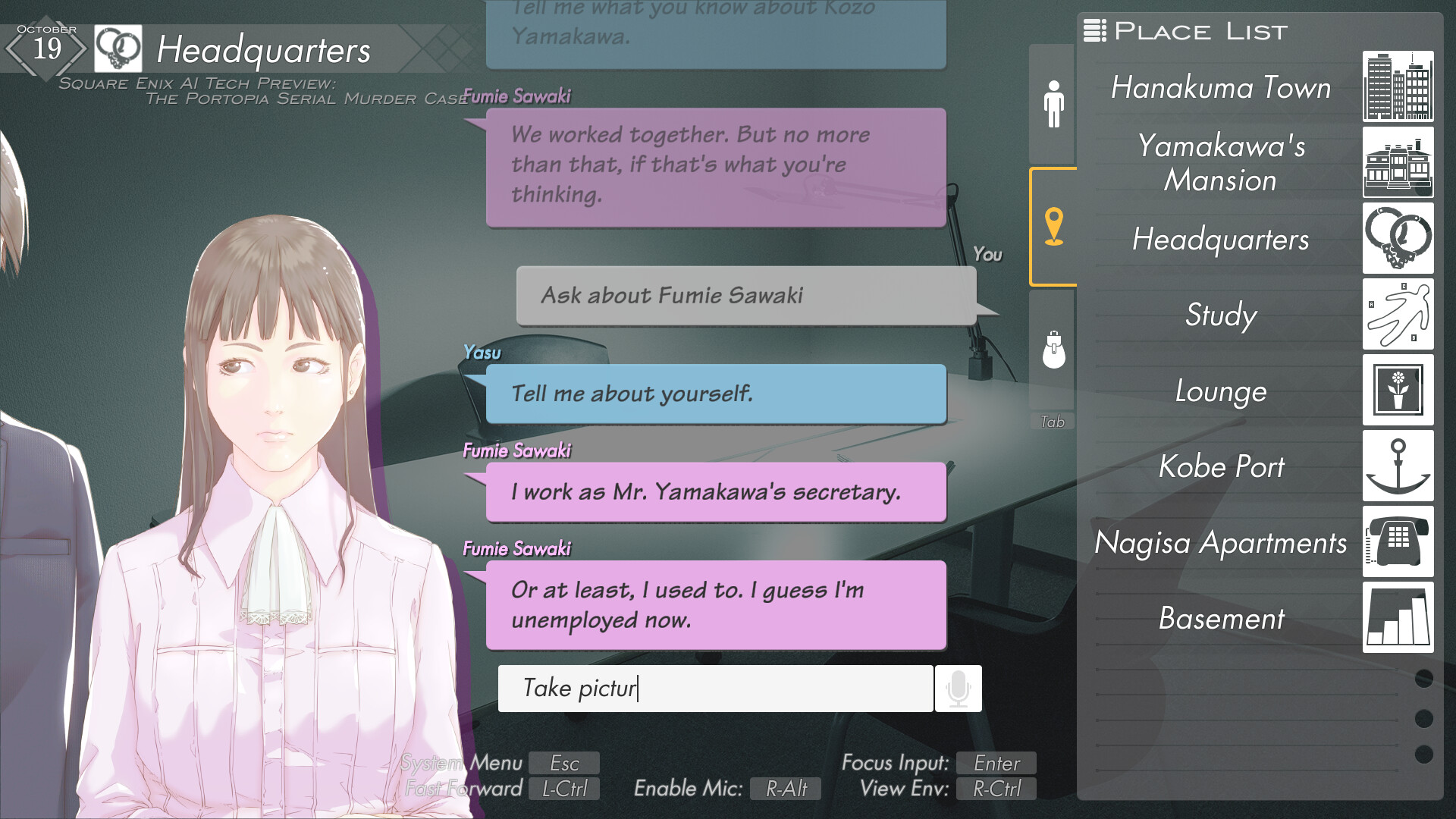

Por último, aunque hay una gran promesa para la IA generativa y conversacional en los juegos… todavía no estamos del todo allí. De hecho, Square Enix parece haber retrasado el medio unos 30 años con su versión “AI Tech Preview” de una súper aventura de apuntar y hacer clic de la vieja escuela llamada Portopia Serial Murder Case. Su intento de integrar el lenguaje natural parece haber fallado por completo en todas las formas imaginables, lo que hace que el juego gratuito sea probablemente uno de los títulos peor revisados en Steam. No hay nada que me gustaría más que conversar sobre Shadowgate o The Dig o algo así, pero definitivamente no es un gran comienzo.

Créditos de imagen: Square Enix